- Регистрация

- 08.11.2019

- Сообщения

- 241

- Благодарностей

- 40

- Баллы

- 28

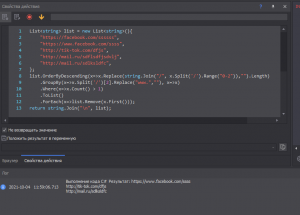

Добрый день. Прошу помощи. Как можно сделать так:

Есть список с ссылками

https://w ww.facebook.com/zzzzzzzzzzzz

http://w ww.facebook.com/zzzzzzzzzzzzaaaaaaaaaaaaaaaa

http:// tiktok.com/ssss

Надо найти повторяющиеся домены , в данном случае 2х facebook. И удалить самый длинный из них

Поставил пробелы в ссылках, так как авто меняет на какой-то виджет

Есть список с ссылками

https://w ww.facebook.com/zzzzzzzzzzzz

http://w ww.facebook.com/zzzzzzzzzzzzaaaaaaaaaaaaaaaa

http:// tiktok.com/ssss

Надо найти повторяющиеся домены , в данном случае 2х facebook. И удалить самый длинный из них

Поставил пробелы в ссылках, так как авто меняет на какой-то виджет